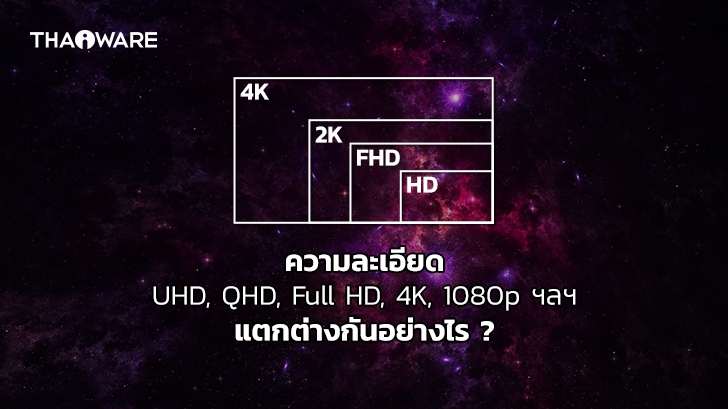

ความละเอียด 720p, 1080p, 1440p, 2K, 4K, 5K, 6L, 8K, HD, FHD, UHD, QHD, ของหน้าจอ คืออะไร ? แตกต่างกันอย่างไร ?

ความละเอียดหน้าจอ (Screen Resolution) ที่เราหยิบมากล่าวถึงในบทความนี้จะเกี่ยวกับความละเอียดของหน้าจอแสดงผล อาจจะเป็นของหน้าจอคอมพิวเตอร์, จอทีวี, จอสมาร์ทโฟน หรือแท็บเล็ต รวมไปถึงความละเอียดของวิดีโอก็ได้เช่นกัน เพราะใช้วิธีวัดค่าความละเอียดเหมือนกัน

จำนวนพิกเซลคือ สิ่งที่เราใช้ระบุความละเอียดของหน้าจอแสดงผลพิกเซล (Pixel) เป็นคำที่มีที่มาจากคำว่า “Picture” ที่แปลว่ารูปภาพ และ “Element” ที่แปลว่า องค์ประกอบ เจ้า Pixel นี้มีลักษณะเป็นรูปสี่เหลี่ยม ในการแสดงผลบนหน้าจอ Pixel จำนวนมากจะเรียงต่อกันเป็นตาราง โดย Pixel แต่ละจุดก็จะมีค่าสีที่แตกต่างกันออกไป เนื่องจาก Pixel นั้นมีขนาดที่เล็กมาก สายตาของเราจึงแยกมันไม่ออก (ถ้าไม่ได้พยายามซูมดูอย่างจริงจัง) แทนที่จะเห็นว่ามันเป็นก้อนสี่เหลี่ยมเรียงชิดติดกัน สมองของเราได้จัดการประมวลผลรวม Pixel ให้กลายเป็นภาพบนหน้าจอที่สวยงาม

ในการแสดงผล ยิ่งมีจำนวนพิกเซลสูงมากเท่าไหร่ ความคมชัดของภาพก็จะยิ่งสูงขึ้นเท่านั้น อย่างหน้าจอที่เห็นในภาพด้านล่างนี้ เป็นหน้าจอขนาด 9.6 นิ้ว ที่มีความละเอียดเพียง 32 x 32 พิกเซล ทำให้เราเห็นเม็ดพิกเซลอย่างชัดเจน แน่นอนว่าความละเอียดมันต่ำมาก ความคมชัดไม่ต้องพูดถึง มันเอาไว้สำหรับคนรักงานศิลปะแนว Pixel art เท่านั้นเอง ถ้าเอามารับชมรายการทีวี หรือใช้ร่วมกับคอมพิวเตอร์ คงไม่ไหว ดูข้อมูลบนหน้าจอไม่รู้เรื่องเป็นแน่ …

สำหรับบทความนี้ จะพามาทำความรู้จักกับ ชื่อศัพท์เทคนิค ที่เกี่ยวข้องกับความละเอียดของหน้าจอ มากมาย ต่อไปจะได้แยกออกว่า แต่ละอันคืออะไรบ้าง อันไหนที่ภาพชัดกว่ากัน เป็นต้น มาดูกันเลย …

อัตราส่วนภาพ (Aspect Ratio) กับความละเอียดของหน้าจอแสดงผล (Screen Resolution)

ปัจจุบันอัตราส่วนภาพ (Aspect Ratio) กับความละเอียดของหน้าจอแสดงผล (Screen Resolution) จะมีการมาตรฐานที่ชัดเจนอยู่ แม้ผู้ผลิตสามารถทำขนาดหน้าจอแสดงผลให้แตกต่างจากค่ามาตรฐานได้ แต่ส่วนใหญ่ก็จะไม่แตกต่างไปจากเดิมมากนัก

อัตราส่วนภาพ กับค่าความละเอียดของหน้าจอแสดงผล

- อัตราส่วนภาพ 4:3 (กว้าง x สูง) มีความละเอียดอยู่

- 640 × 480

- 800 × 600

- 960 × 720

- 1,024 × 768

- 1,280 × 960

- 1,400 × 1,050

- 1,440 × 1,080

- 1,600 × 1,200

- 1,856 × 1,392

- 1,920 × 1,440

- 2,048 × 1,536

- อัตราส่วนภาพ 16:10 (กว้าง x สูง) มีความละเอียดอยู่ที่

- 1,280 × 800

- 1,440 × 900

- 1,680 × 1050

- 1,920 × 1,200

- 2,560 × 1,600

- อัตราส่วนภาพ 16:9 (กว้าง x สูง) มีความละเอียดอยู่ที่

- 1,024 × 576

- 1,152 × 648

- 1,280 × 720

- 1,366 × 768

- 1,600 × 900

- 1,920 × 1,080

- 2,560 × 1440

- 3,840 × 2160

ซึ่งในบทความนี้เราจะพูดถึงอัตราส่วนภาพ กับความละเอียดของหน้าจอแบบ 16:9 เป็นหลักนะครับ

HD หรือ High-Definition คืออะไร ?

คำว่า “เฮชดี (HD)” นั้น แท้จริงแล้ว ย่อมาจากคำว่า “High Definition” หรือถ้าแปลไทย ก็จะได้ความหมายว่า “ความคมชัดสูง” ซึ่งหลายคนอาจจะคุ้นชิน กับการเรียกมันว่า “Hi-Def” หรือ “ไฮเดฟ” นั่นเอง (อันนี้ก็แล้วแต่ที่จะเรียก)

โดย “HD” นั้น ก็ถูกจัดว่าเป็นหนึ่งในคำศัพท์เชิงเทคนิค ที่ถูกนำมาใช้จนเกร่อ (แถมยังมีการใช้ผิดอยู่บ่อยครั้ง) จนกระทั่งในที่สุดมันก็กลายเป็นคำที่ใช้เมื่อต้องการสื่อความหมายถึง อะไรก็ตามที่เพิ่มรายละเอียด หรือคุณภาพให้สูงขึ้นกว่าเดิมกว่าสิ่งที่เคยมีมาก่อน (อารมณ์เหมือนบ้านเราที่เรียกแฟ้บแทนผงซักฟอก)

ความละเอียด 540p qHD คืออะไร ?

สำหรับความละเอียด 540p หรือ qHD นั้นจะอยู่ที่ 960 x 540 พิกเซล โดยคำว่า “qHD” และ “QHD” นั้น ถึงแม้ว่าแม้จะเขียนคล้ายกัน (อาจจะทำให้หลายคนสับสน เหมือนกับ MBPS ละต่างกันแค่ตัวพิมพ์เล็ก “q” กับตัวพิมพ์ใหญ่ “Q” เท่านั้น

แต่ในความเป็นจริงแล้ว ถ้าเป็นในเรื่องของ ความละเอียดนั้น มันมีความแตกต่างกันมากอยู่นะครับ เพราะคำว่า “qHD “นั้นมาจากคำว่า “quarter of Full HD” หมายความว่า มันมีความละเอียดน้อยกว่า FHD ถึง 4 เท่ากันเลยทีเดียว

เปรียบเทียบความละเอียดระหว่าง qHD, FHD

- qHD (quarter High Definition) : 960 x 540 = 518,400 พิกเซล

- FHD (Full HD) : 1,920 x 1,080 = 2,073,600 พิกเซล

ความละเอียด 720p HD และ 900p HD+ คืออะไร ?

ในอดีต สมัยที่เครื่องรับโทรทัศน์ หรือทีวี ที่มีความคมชัดสูง (HD TV) เพิ่งเปิดตัวใหม่ๆ ทางสถานีโทรทัศน์ หรือช่องทีวี ต่างๆ ก็ได้ปรับตัวมาฉาย หรือส่งภาพที่ความละเอียด 1280 x 720 พิกเซล เรียกโดยย่อว่า 720p ตัว “p” ที่ว่านี้ไม่ได้หมายถึง คำว่า Pixel แบบที่เราคุ้นเคยนะครับ แต่จริงๆ แล้ว “p” ในที่นี้ มาจากคำว่า “Progressive Scan” นั่นเอง

ข้อมูลเพิ่มเติม : Progressive Scan เป็นเทคนิคด้านการแสดงผลรูปแบบหนึ่ง อีกรูปแบบ คือ Interlaced Scan ที่นิยมใช้ในการถ่ายทอดสัญญาณทีวี เนื่องจากใช้แบนด์วิธต่ำกว่า แต่ก็มีคุณภาพด้อยกว่าเช่นกัน ซึ่งเราจะไม่กล่าวถึงมันในบทความนี้

และเนื่องจากหน้าจอแบบเก่า ส่วนใหญ่จะแสดงผลที่ความละเอียด 720 × 480 พิกเซล หรือไม่ก็ 720 x 576 พิกเซล จอรุ่นใหม่ที่มีความละเอียด 1,280 x 720 พิกเซล ก็จึงถูกเรียกมันว่าจอ HD นั่นเอง

อนึ่ง ก่อนที่จะเข้าสู่ยุค ความละเอียด FHD อันที่จริงแล้ว ระหว่างนั้น ก็มีจอแบบ HD+ ความละเอียด 1,600 x 900 พิกเซล หรือ 900p ออกมาด้วยนะครับ

สรุปโดยย่อ :

- 720p / HD หมายถึงความละเอียด 1,280 x 720 พิกเซล

- 900p / HD+ หมายถึงความละเอียด 1,600 x 900 พิกเซล

ความละเอียด 1080p FHD (หรือ Full HD) คืออะไร ?

และต่อมา เมื่อหน้าจอถูกพัฒนาให้มีความละเอียดสูงขึ้นไปอีก ทำให้คำว่า “FHD” (ย่อมาจากคำว่า “Full HD”) ถูกสร้างขึ้นมา ตามการเปลี่ยนแปลงของเทคโนโลยี

โดย FHD นั้นจะมีความละเอียด 1,920 x 1,080 พิกเซล หรือที่นิยมเรียกว่า 1080p ซึ่งความละเอียดนี้ได้กลายเป็นความละเอียดมาตรฐานของ ที่มีหน้าจอแสดงผล (Display Screen) หลายอย่าง ไม่ว่าจะเป็นสมาร์ททีวี (Smart TV), สมาร์ทโฟน (Smartphone), หน้าจอคอมพิวเตอร์ (Monitor) และหน้าจอของ(Notebook / Laptop Screen) เป็นต้น

เกร็ดความรู้ : ปัจจุบันสถานีโทรทัศน์ส่วนใหญ่ ก็เปลี่ยนมาใช้ความละเอียด FHD กันหมดแล้ว

และไม่ว่าจะเป็น ทั้งความละเอียดแบบ HD และ FHD ต่างใช้อัตราส่วนภาพแบบ 16:9 ที่สามารถเรียกได้ว่าเป็นความกว้างแบบจอกว้าง (Widescreen) แต่อย่างไรก็ตาม บนสมาร์ทโฟน จะสลับด้านกันเป็น 9:16 นะ เพราะปกติเราถือสมาร์ทโฟนในแนวตั้ง

สิ่งหนึ่งที่ควรจดจำไว้ คือ ไม่ว่าหน้าจอจะมีขนาดเท่าไหร่ จำนวนพิกเซลจะมีจำนวนเหมือนเดิมเสมอ ที่ต่างกัน คือ ขนาดของเม็ด Pixel เท่านั้น แน่นอนว่า FHD บนจอสมาร์ทโฟนย่อมมีความคมชัดสูงกว่าบนจอทีวีขนาดใหญ่ เราเรียกสิ่งนี้ว่า Pixels-per-inch (ppi) ถ้าสนใจเรื่องนี้

สรุปโดยย่อ :

- FHD / 1080p หมายถึงความละเอียด 1,920 x 1,080 พิกเซล

ความละเอียด 2K QHD/WQHD หรือ 1440p คืออะไร ?

คำว่า “QHD” (ย่อมาจากคำว่า “Quad HD”) จะมีความละเอียด 2,560 x 1,440 พิกเซล หรือเรียกว่า 1440p ก็ได้เช่นกัน โดยมันมีอัตราส่วนภาพ 16:9 ซึ่งก็เป็นความกว้างแบบ Widescreen แต่ด้วยเหตุผลในการโฆษณา ผู้ผลิตบางรายเลยเติมตัว “W’ ลงไปข้างหน้า และเรียกมันว่า WQHD ถึงแม้ว่าความจริงมันก็เหมือนกับจอ QHD นั่นแหละ

และบ่อยครั้งที่ความละเอียด QHD ถูกเรียกว่า 2K เรื่องนี้อันที่จริงก็ไม่ถูกต้องสักทีเดียวนะครับ แม้ทุกวันนี้มันจะเป็นเรื่องที่ยอมรับกันโดยทั่วไปแล้วก็ตาม

ต้องอธิบายก่อนว่า 2K (รวมถึง 4K และ 8K ด้วย) แท้จริงแล้วมัน เป็นมาตรฐานความละเอียดที่กำหนดขึ้นมาโดย Digital Cinema Initiatives (DCI) ซึ่งเป็นกลุ่มของสตูดิโอภาพยนตร์ที่ก่อตั้งขึ้นเพื่อวางข้อกำหนดสำหรับสถาปัตยกรรมโรงภาพยนตร์ดิจิตอล

โดยทางกลุ่มดังกล่าว ได้กำหนดมาว่า 2K คือ ภาพยนตร์ที่ฉายด้วยความกว้างละเอียด 2,048 พิกเซล แต่ความสูงจะมีความหลากหลาย เพราะมันขึ้นอยู่กับ Cinemascope (อัตราส่วนภาพของการถ่ายทำภาพยนตร์ จะแตกต่างจากจอแสดงผล เราขอไม่ลงรายละเอียดในส่วนนี้นะครับ)

มาตรฐานความละเอียด 2K ของ DCI

| Format | Resolution | Display Aspect Ratio | Pixels |

|---|---|---|---|

| DCI 2K (Native Resolution) | 2048 × 1080 | 1.90:1 (256:135, ~17:9) | 2,211,840 |

| DCI 2K (Flat Cropped) | 1998 × 1080 | 1.85:1 | 2,157,840 |

| DCI 2K (CinemaScope Cropped) | 2048 × 858 | 2.39:1 | 1,755,136 |

ซึ่งหน้าจอความละเอียด 2,048 x 1,080 พิกเซล จริงๆ แล้วนั้นหายากมากๆ โดยแทบไม่มีวางจำหน่ายในท้องตลาดเลย ผู้ผลิตจอส่วนใหญ่จึงวางขายหน้าจอโดยใช้คำโฆษณาว่าเป็นหน้าจอความละเอียด 2K QHD รวมกันเลย แม้ความจริง หน้าจอ QHD ที่มีความละเอียด 2,560 x 1,440 พิกเซล จะมีความละเอียดสูงกว่า 2K แบบพื้นฐานก็ตาม

สรุปโดยย่อ :

- QHD / 1440p หมายถึงความละเอียด 2,560 x 1,440 พิกเซล

- 2K หมายถึงความละเอียด 2,048 x 1,080 พิกเซล

ความละเอียด 4K UHD หรือ 2160p คืออะไร ?

คำว่า “4K” และคำว่า “Ultra High Definition (UHD)” เป็น 2 คำที่สามารถสร้างความสับสนให้แก่ผู้ใช้ได้ง่าย ๆ เพราะแม้สองสิ่งนี้จะแตกต่างกัน แต่มันกลับถูกใช้แทนกันเป็นประจำราวกับว่ามันเป็นสิ่งเดียวกัน

หน้าจอความละเอียด 4K ที่แท้จริงนั้น เขาจะใช้กันในวงการมืออาชีพ และภาพยนตร์ดิจิทัล โดยมันจะมีความละเอียด 4,096 x 2,160 พิกเซล ส่วนความละเอียด UHD ที่เราเห็นกันในหน้าจอระดับทั่วไป และเป็นมาตรฐานการออกอากาศ จะมีความละเอียดเป็น 4 เท่า ของ FHD 1080p นั่นก็คือ 3,840 x 2,160 พิกเซล จะสังเกตได้ว่าจำนวนพิกเซล และอัตราส่วนภาพระหว่างหน้าจอในโรงภาพยนตร์ กับหน้าจอตามบ้านก็จะมีความแตกต่างกัน โดย UHD ใช้อัตราส่วนภาพแบบ 16:9 ทำให้มันรองรับเนื้อหาแบบ FHD หรือ 1080p ได้โดยไม่มีปัญหา

แต่ถึงอย่างไรก็ตาม ทั้งความละเอียดแบบ 4K และ UHD เราก็สามารถเรียกได้เหมือนกันว่า 2160p เพื่อให้เหมือนกับมาตรฐานของ HD ที่มีอยู่เดิม แต่มันก็ยิ่งทำให้เรื่องมันซับซ้อนยิ่งกว่าเดิม เพราะแม้จำนวนพิกเซลบนจอจะแตกต่างกันไม่มาก แต่มันก็คือแตกต่างกันอยู่ดี ตอนนี้ผู้ผลิตบางรายที่เลือกระบุแค่ว่าเป็นจอความละเอียด UHD เท่านั้น เพื่อลดความสับสน แต่ในแง่ของการตลาดจอทีวีแล้ว ส่วนใหญ่ก็ยังใช้สองคำนี้ร่วมกันอยู่ดี

สรุปโดยย่อ :

- 4K UHD / 2160p หมายถึงความละเอียด 3,840 x 2,160 พิกเซล

- 4K หมายถึงความละเอียด 4,096 x 2,160 พิกเซล

ความละเอียด 5K คืออะไร ?

คำว่า “5K” หมายถึงการแสดงผลที่มีความละเอียดในแนวนอนประมาณ 5,000 พิกเซล ซึ่งส่วนใหญ่แล้ว หน้าจอก็จะทำออกมาที่ความละเอียด 5,120 x 2,880 พิกเซล ในอัตราส่วนภาพ 16:9 เพื่อให้แสดงเนื้อหาคุณภาพระดับ UHD หรือ FHD ได้เต็มจอ

ความละเอียดระดับ 5K ไม่ใช่ความละเอียดซึ่งเป็นที่นิยมมากนัก ส่วนใหญ่แล้วจะใช้แค่ในจอคอมพิวเตอร์ที่ต้องการ ค่า PPI สูง ที่ต้องการความคมชัดสูงเป็นพิเศษ เพราะเนื่องจากรายการทีวี และภาพยนตร์ดิจิทัลในปัจจุบันนี้จะบันทึกที่ความละเอียด 4K หรือ 8K เสียเป็นส่วนใหญ่

อุปกรณ์ที่รองรับความละเอียด 5K ที่มีในท้องตลาดก็อย่างเช่น

- หน้าจอของ Apple iMac รุ่น 27 นิ้ว

- มอนิเตอร์ LG 27 นิ้ว Ultrafine 5K

- มอนิเตอร์ Dell 27 นิ้ว Ultrasharp

- และอุปกรณ์แสดงผลอื่นๆ

- 5K หมายถึงความละเอียด 5,120 x 2,880 พิกเซล

ความละเอียด 6K คืออะไร ?

ถึงแม้ว่า 4K จะเริ่มเป็นที่นิยมมากขึ้นแล้ว และมีจำนวนผู้ใช้เพิ่มขึ้นเรื่อย ส่วนความละเอียดระดับ 8K ก็เริ่มมีให้เห็นบ้างแล้ว แต่ก็เป็นเทคโนโลยีที่มีราคาสูงมาก ช่องว่างระหว่าง 4K กับ 8K ที่ค่อนข้างกว้างก็เลยทำให้มีผู้ผลิตอุปกรณ์ ที่รองรับ ความละเอียด 6K ออกมา แต่ว่าก็มีตัวเลือกค่อนข้างจำกัด

โดย ความละเอียด 6K ก็หมายถึงการแสดงผลที่มีความละเอียดในแนวนอนประมาณ 6000 พิกเซล อย่างเช่น หน้าจอ Pro Display XDR ของ Apple ก็ทำความละเอียดมา 6,016 x 3,384 พิกเซล อัตราส่วนภาพ 16:9 ในขณะที่กล้อง Blackmagic Pocket Cinema Camera 6K Pro เลือกทำมาที่ 6,144 x 3,456 พิกเซล

Total Users : 25501

Total Users : 25501 Total views : 47401

Total views : 47401 Who's Online : 0

Who's Online : 0